把大语言模型装进电脑里很难吗?当然不会!跟着我的步骤,有电脑操作基础就能轻松实现!我们对笔记本电脑的需求不再仅仅局限于轻薄便携或者性能强劲的单一维度,而是渴望拥有一台能够完美融合多种优势的全能型设备。ROG 幻16 Air 就是这样一款令人瞩目的笔记本电脑。

ROG 幻16 Air外观设计简约个性,航空铝一体成型,A面光线矩阵设计独具匠心。便携性出色,轻约 1.85kg,最薄至14.9mm。无论是出差、旅行还是日常通勤,都能轻松装入背包,随时随地陪伴在你身边。这样的便携性,让你不再受限于使用场景,无论身在何处,都能轻松开启工作或娱乐模式性能堪称王者。

搭载英特尔酷睿 Ultra9 185H 处理器、32G内存和 NVIDIA GeForce RTX 4070 笔记本电脑 GPU,还内置AI专属芯片NPU,提供约50TOPS智能算力。ROG 幻16 Air 运行本地大语言模型优势明显,强大处理器、充足内存和 AI 专属芯片为模型运行提供坚实基础。

在ROG 幻16 Air的配置下,运行7B、8B、十几B的大模型完全没问题,效率非常高。为了便于安装管理和后期便于使用,我们采用的安装方案是 OLLama + Open_WebUI(docker) 。

OLLama是一个开源的大语言模型管理工具。通过简单的安装,就可以对开源的大语言模型进行下载、配置、部署运行。但是界面简陋,只提供控制台界面。

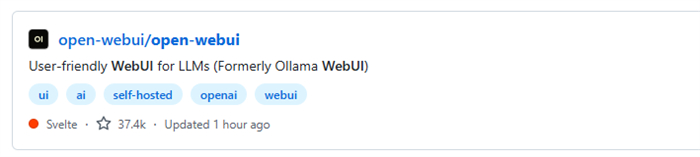

Open_WebUI 是为了弥补Ollama交互界面的不足,提供了一套便于交互操作的页面应用服务。使用docker版本是为了让安装更简单,不用考虑更多的版本和依赖问题。

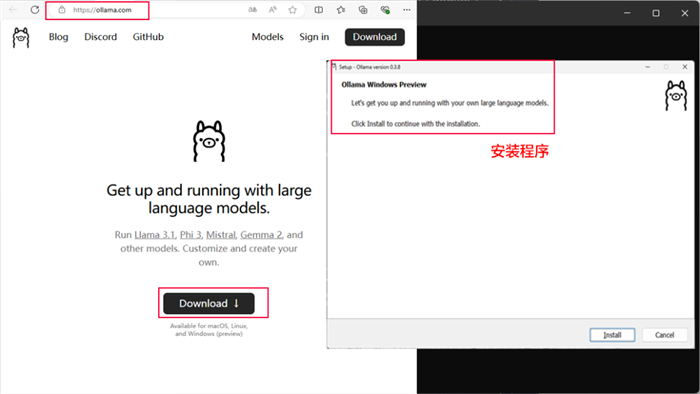

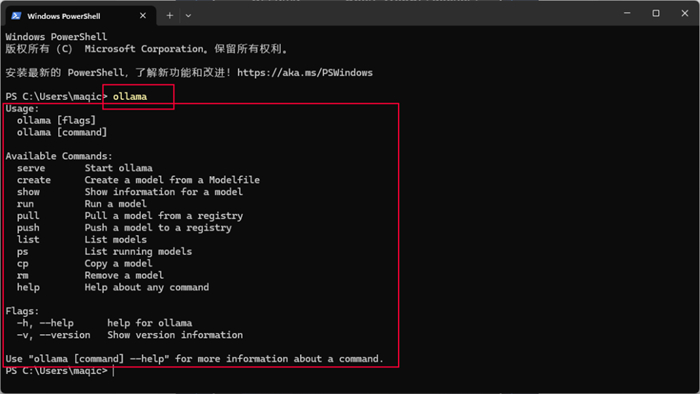

首先进入Ollama官网,下载最新的Ollama安装包,安装好之后会弹出一个powershell命令提示符。在窗口中输入ollama,出现以下提示就说明安装好了。

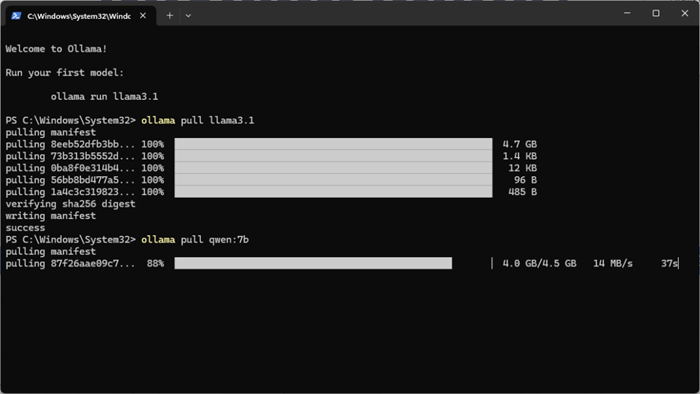

现在比较火的模型比如阿里的千问、谷歌的gemma以及meta自己的llama3。比如要下7b量级的千问,指令则为:ollama pull qwen:7b。如果要下8b量级的llama3,指令则为:ollama pull llama3:8b。都下载好了,咱们如果要运行qwen,就直接输入ollama run qwen:7b就好了。

但现在存在两个问题。第一个在powershell中运行大语言模型显得有点过于简陋,第二个目前这些大语言模型并不支持多模态。也就是并不识别你发给它的图片,这就在功能上比较受限,那该如何解决呢?

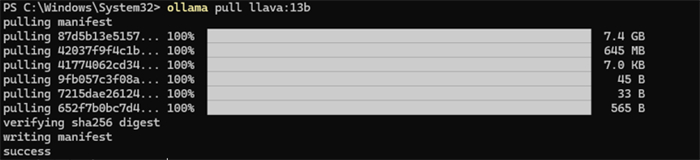

首先解决多模态问题,依旧是下载一个大模型,叫做llava。这里我建议下载llava13b,同样的pull指令下载,ollama pull llava:13B。模型都准备好了,咱们就要解决第二个问题了。安装一个友好的交互界面!

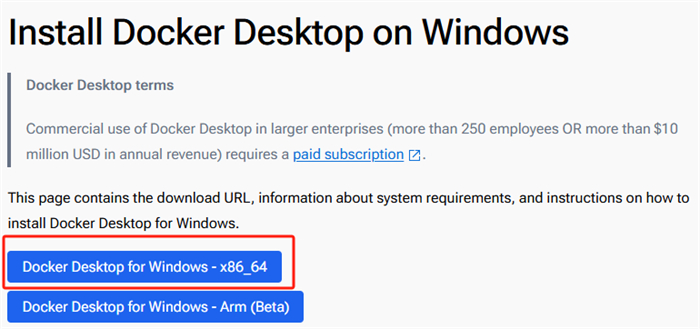

下载一个docker,也就是windows版的docker。浏览器中直接搜索下载安装。但一定得注意你下载得版本!我们需要下载的是Windows-X86_64版本。

下载完之后访问github,搜索open-webui。点进去往下拉找到下图红框内容复制下来,再打开一个pwoershell,把复制的内容粘贴进去回车,等待进度条走完就好了。

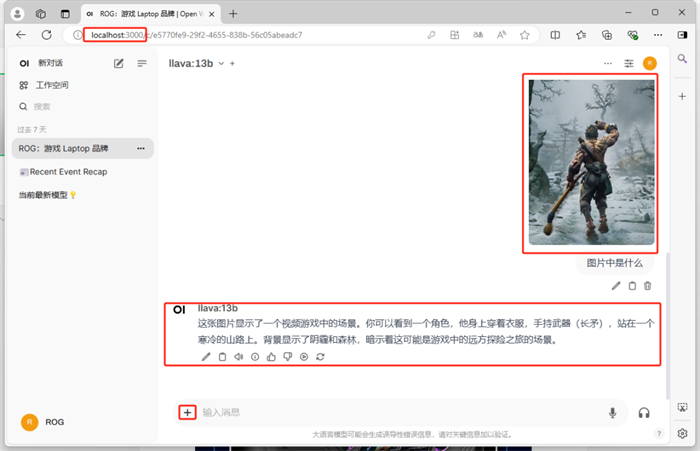

这时,打开一个网页,输入 localhost:3000, WebUI 就出现了。选择刚才下好的 llava:13b,给它一张图让它描述一下,成功了,速度很快,描述的也非常精准。

当然本地部署AI应用方式不止如此,比如还可以集成Stable Diffusion,这样你就可以让它帮你画画了。同样也可以帮助你完成表单文档和工作流,如果你感兴趣,请持续关注我们。

如果大家需要购买或者体验ROG笔记本,或者在软件安装和配置中碰到问题,都可以到身边的线下门店进行咨询,线下门店的专业人员会帮你解决所有问题!

免责声明:本文图片源自网络,如有侵权请联系我们删除。

搞趣网发布此文仅为传递信息,不代表搞趣网认同其观点。